Opinião

‘Eu te darei o céu meu bem, e o meu amor também’

Devemos estar atentos: o amplo chamado à colaborações para o PL que propõe regulamentar o uso da IA no Brasil pode ser um movimento meramente exploratório e performativo

Por

Elen Nas

02.07.2024 20h02

Começo este artigo esclarecendo que o tom crítico nada têm a ver com ser contra à regulamentação da IA, mas sim com as contradições que envolvem a proposta de regulamentação em curso no Senado.

A começar, o fato de Comissão Temporária Interna Sobre a Inteligência Artificial no Brasil, a CTIA, ser composta por senadores de partidos majoritariamente identificados com as pautas liberais conservadoras: Podemos, MDB, União, PDT, PSD, PT, PSB, PL e PP. O texto proposto, contudo, parte de pessoas, grupos e organizações progressistas, que demonstram grande atenção à garantia dos direitos individuais e sociais para todos. O processo de tramitação ouviu especialistas, acadêmicos e ativistas de direitos digitais comprometidos com os princípios de justiça para evitar que a IA cause danos. O texto agrega contribuições importantes, mas está sendo conduzido por representantes mais suscetíveis às pressões da indústria.

Nessa toada, a maior parte dos elementos que conjugam o projeto o tornaram mais um conjunto de recomendações e reflexões do que uma legislação de fácil implementação. O PL 2338/2023 prometeu tanto que poderia ser lido com a trilha sonora ao fundo: a canção de Roberto Carlos Eu te darei o céu, de 1966.

Enquanto discutimos a velocidade dos avanços em IA e a necessidade de regulamentação igualmente rápida, a implementação dos princípios de uma IA responsável segue um ritmo muito mais lento

As contradições entre a liderança do campo conservador e a falta de engajamento do campo democrático no Congresso e nas organizações da sociedade civil ajudam a explicar o andamento lento da proposta, a despeito do clamor da sociedade por urgência.

Embora no conjunto das 30 páginas hajam emendas indiquem como observar a eficiência da lei, existem muitas lacunas – como deixar à cargo dos agentes de IA informarem “de forma clara e facilmente acessível” de que modo estão garantindo a observância dos direitos à privacidade, proteção de dados pessoais, direito à não discriminação, direito a contestar decisões, direito à informação sobre estar interagindo com IA’s e o direito à explicação sobre decisão, entre outros.

Se há algo de positivo neste processo, é que pouco a pouco está havendo uma tomada de consciência, nesta terça 2, o Conselho Diretor da ANPD colocou um freio à proposta da Meta para a utilizar os dados pessoais dos seus usuários para treinamento de IA. Falta de clareza na divulgação sobre o uso e a prerrogativa do usuário de aceitá-lo ou recusá-lo. Além disso, os ajustes de configurações para tomar essa decisão não são de fácil acesso.

Vale lembrar também que o “direito à explicação” presente na regulamentação européia foi também prevista na LGPD, mas logo restringida para decisões automatizadas relacionadas à concessão de crédito – e não exatamente o caso direto de tratamento dos dados pessoais.

Devemos estar atentos: o amplo chamado à colaborações para o PL que propõe regulamentar o uso da IA no Brasil pode ser um movimento meramente exploratório e performativo. Temos o risco de uma “lavagem ética” que se resume em palavras bem organizadas e situadas nos lugares certos, porém sem real impacto nas soluções a que se propõe.

Não é por acaso que o projeto de lei em questão esteja retrocedendo em alguns pontos, ainda em seu processo de tramitação. A Coalizão Direitos na Rede chamou atenção dos substitutivos ao PL 2338 recuarem nos tópicos relacionados à identificação biométrica em sistemas de vigilância públicos e com usos na segurança pública e sistema criminal, desde que são sistemas que já vêm apresentando falhas em mais de 90% e com alto risco de danos, em especial para as pessoas que já sofrem algum tipo de preconceito.

Algo a se ter em vista é que, enquanto se fala da velocidade exponencial nos desenvolvimentos de IA e das necessidades em responder com a mesma velocidade em termos de regulamentação, o tempo de colocar em prática os preceitos de uma IA responsável é outro, muito mais lento.

Fundamentalmente, quando se fala do controle humano da IA, é necessário perguntar quais humanos estão no controle. A soberania do país e de seus territórios poderão ser prejudicadas por tecnologias de escala global desenvolvidas e modeladas sob interesses e perspectivas culturais distintas das nossas.

Para garantir a transparência, explicabilidade, inteligibilidade, segurança e confiança da IA, é necessário viabilizar sua auditabilidade através de programas de formação de auditores que representem as mais diversas camadas da sociedade.

Do mesmo modo, a implementação de tais tecnologias devem ser debatidas e consultadas com a população. Por incrível que pareça, o novo texto substitutivo do PL 2338/2023 prevê estas consultas ‘de baixo para cima’, algo que, frente às contradições expostas, soa como a promessa romântica na voz de Roberto Carlos: “eu te darei o céu meu bem, e o meu amor também”.

É preciso ampliar a “massa crítica” no debate da regulamentação, de modo que o público e seus representantes entendam os reais riscos e façam valer os princípios de justiça em uma sociedade democrática. O assunto é sem dúvida urgente, pois os sistemas de IA já estão disponíveis e causando danos, enquanto a visão sobre os seus benefícios é ainda difusa. Certamente existem benefícios no campo da ciência, educação e saúde, mas há muito a ser debatido sobre como conduzir estes processos para melhores resultados.

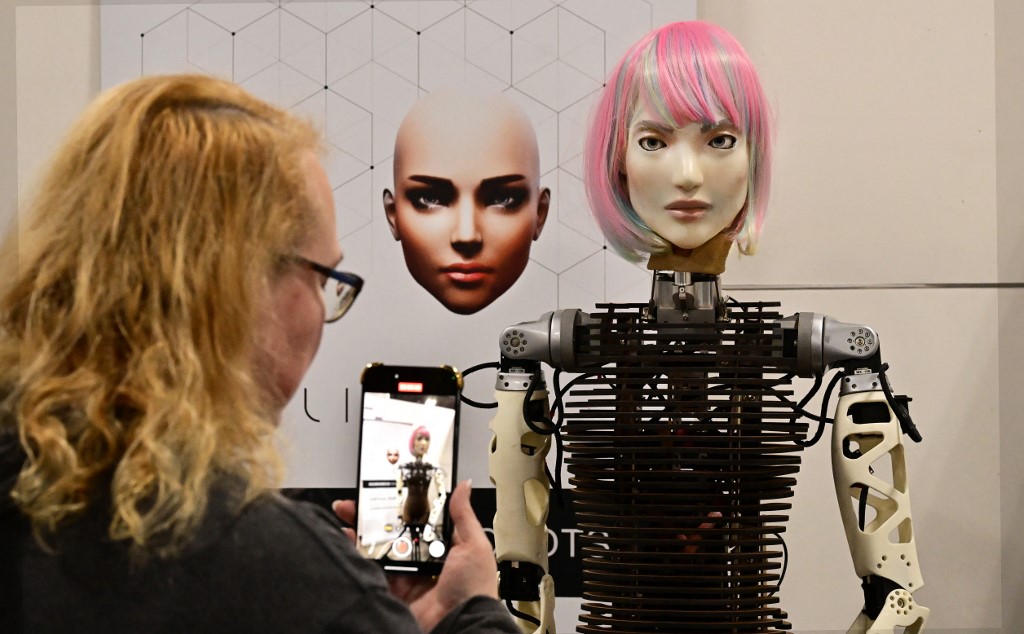

Enquanto agregar responsabilidade à IA não avança, devemos exigir informações precisas em todas as instâncias. Por exemplo: como as instituições públicas do país estão adotando a IA, em que áreas, para quais finalidades. Como as empresas que acessam e tratam dados do grande público o fazem, como as IAs estão sendo utilizadas nos departamentos de RH e de que maneiras o Estado planeja interferir nos maus usos por parte das empresas privadas. Estes são alguns dos muitos assuntos que se perdem no ‘véu de fumaça’ quando tudo que se vê é a romantização do nosso robô amigo imaginário.

Este texto não representa, necessariamente, a opinião de CartaCapital.

Apoie o jornalismo que chama as coisas pelo nome

Depois de anos bicudos, voltamos a um Brasil minimamente normal. Este novo normal, contudo, segue repleto de incertezas. A ameaça bolsonarista persiste e os apetites do mercado e do Congresso continuam a pressionar o governo. Lá fora, o avanço global da extrema-direita e a brutalidade em Gaza e na Ucrânia arriscam implodir os frágeis alicerces da governança mundial.

CartaCapital não tem o apoio de bancos e fundações. Sobrevive, unicamente, da venda de anúncios e projetos e das contribuições de seus leitores. E seu apoio, leitor, é cada vez mais fundamental.

Não deixe a Carta parar. Se você valoriza o bom jornalismo, nos ajude a seguir lutando. Assine a edição semanal da revista ou contribua com o quanto puder.